科技改變生活 · 科技引領未來

<ul id="os2sc"></ul> <del id="os2sc"></del>

科技改變生活 · 科技引領未來

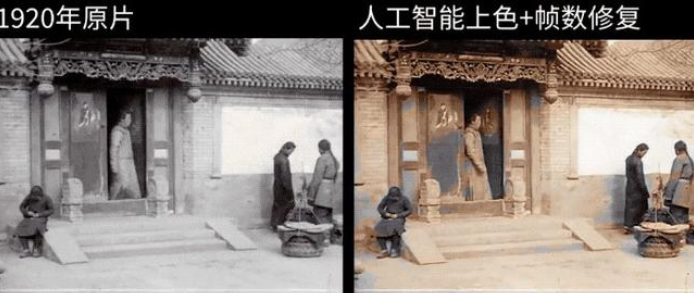

最近,B站上有人將曾經加拿大攝影師在1920到1929在北京拍攝的黑白視頻,經過自己對歷史的了解,以及人工智能的一系列操作之后,一幅彩色的百年前的北京真實視頻就展現在了我們的眼前。

修復這個視頻的過程,主要有三部分,分別是補幀、上色和分辨率擴增。簡單點說就是讓視頻變得更流暢,比如把 24 幀變成 60 幀;讓黑白視頻變彩色;讓視頻變得更清晰,比如把 480P 變成 4K 分辨率。

具體到工具,補幀用的是 DAIN,上色用的是 DeOldify,分辨率擴增用的是 ESRGAN。

AI 是怎么修復老片的?

先來看補幀的 DAIN。這是一個基于視頻深度信息感知的時間幀插值算法,由上海交通大學,加利福尼亞大學和 Google 多方聯合研發。

為了方便更多用戶使用,研發者還提供了一個免費的 Windows 軟件“DAIN-App”。

在視頻領域,補幀其實不是件多新鮮的事。比如索尼電視的 Motionflow 技術和 AMD 顯卡的 Fluid Motion 都是常見的補幀方案。

它們的具體實現有不同,但原理大同小異,都是用計算機模擬相鄰兩幀間缺失的畫面,讓畫面變得更加流暢。

這些補幀方法都有一定局限性,如果畫面里有大面積運動的物體,或者存在遮擋情況,補出來的影像就不是那么完美了。而 DAIN 所采用的方法,能很好解決這一問題。

DAIN 算法不會直接生成畫面,而是先通過獲取視頻深度信息,檢測出物體遮擋情況。然后,從相鄰像素收集上下文信息,來完成層次特征學習。最后,基于上述信息生成視頻幀。

簡言之,DAIN 在模擬生成一幀畫面之前,額外做了很多工作。它讓計算機知道了一個平面視頻里,不同物體之間的遠近關系和遮擋情況。并且,用了一種更有效率的方式,來對像素點進行采樣,以生成更高質量的畫面。

這樣做的結果是,DAIN 生成的補幀畫面,比起傳統補幀方法,更像真實拍攝的。

在 這段修復的視頻里,如果仔細對比原片和 AI 修復片段,很容易可以感受到 DAIN 補幀的效果。比如下面這個場景里的人物動作,原片能感受到卡頓,而 AI 修復后流暢很多。

視頻上色方面,用到了 DeOldify。

DeOldify 基于一種名為 GAN(生成對抗網絡)的技術,這是一個在深度學習圈非常熱門的項目。GAN 被 AI 界的領袖 Yann LeCun 稱為 “過去 10 年機器學習中最有趣的想法”,它通過兩個神經網絡相互博弈的方式來學習數據,能生成逼真的新內容,其中一個廣為人知的應用,是可以換臉的 Deepfake。

DeOldify 采用了一種改良過的 GAN 模型,即保留了 GAN 訓練的優點(絢爛的色彩),又消除了視頻中物體閃爍等副作用。

不過,DeOldify 所呈現的色彩還原結果,并不一定是真實的情況。

分辨率擴增上用的是 ESRGAN,同樣是 GAN 的應用。

把一張圖片放大超過其原本分辨率,是很多人經常會做的事。這樣的結果是,圖片會變得模糊,因此就有人去研究,怎么把圖片發大超過分辨率,而不變得模糊。

ESRGAN 利用深度學習方法來解決這一問題,相比傳統方法,能得到更好的效果。

人工智能技術與歷史影像的碰撞,無疑給我們了解歷史和社會演變提供了新的角度和體驗,這是現代技術服務人類生活的生動例子。

金悅林

<ul id="useq0"></ul> <dfn id="useq0"></dfn>